Detener el desarrollo de sistemas avanzados de inteligencia artificial en todo el mundo y castigar duramente a quienes violan la moratoria es la única forma de salvar a la humanidad de la extinción, advirtió un investigador de inteligencia artificial de alto perfil.

Eliezer Yudkowsky, cofundador del Instituto de Investigación de Inteligencia Artificial (MIRI – Machine Intelligence Research Institute), escribió un artículo de opinión para la revista TIME el Miércoles, explicando por qué no firmó una petición pidiendo a “todos los laboratorios de Inteligencia Artificial que pausen inmediatamente durante al menos seis meses el entrenamiento de sistemas de inteligencia artificial más potentes que el GPT-4”, un modelo multimodal de lenguaje grande, lanzado por OpenAI a principios de este mes.

Yudkowsky argumentó que la carta, firmada por personas como Elon Musk y Steve Wozniak de Apple, estaba “pidiendo muy poco para resolver” el problema planteado por el rápido y descontrolado desarrollo de la IA.

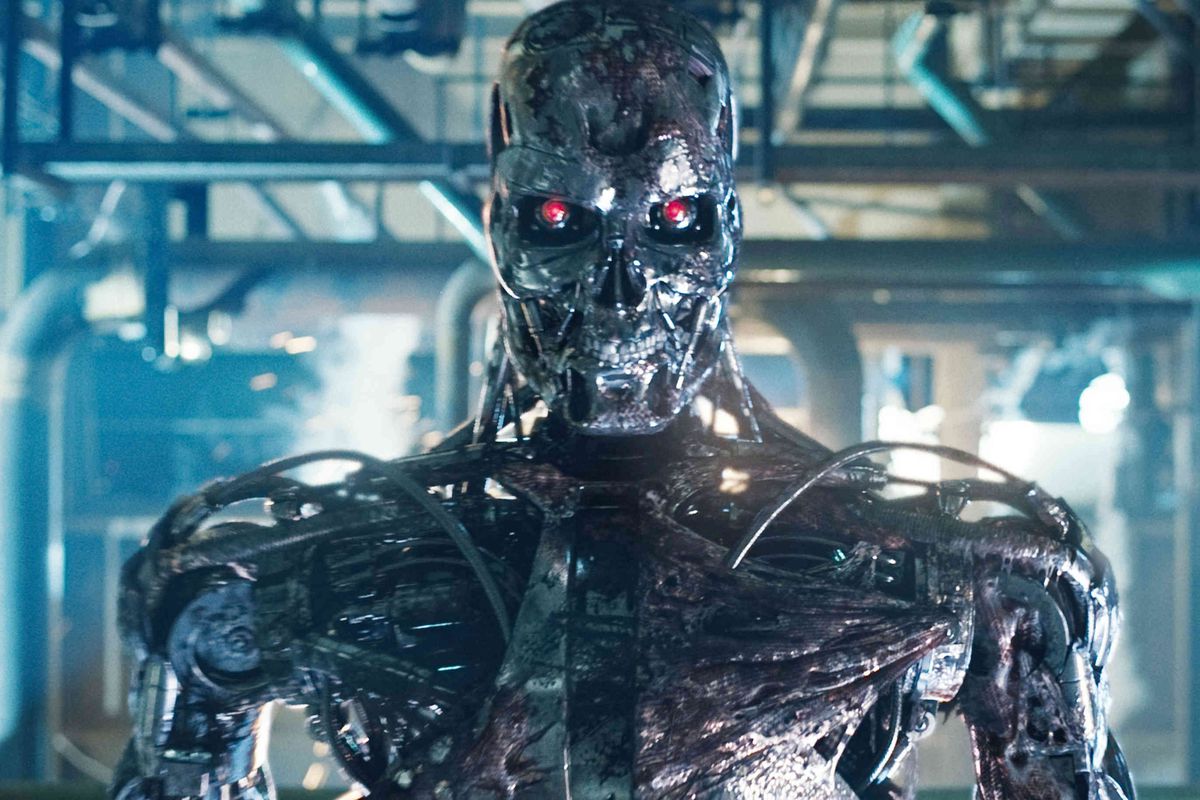

“El resultado más probable de construir una IA inteligente sobrehumana, en algo remotamente parecido a las circunstancias actuales, es que literalmente todos en la Tierra morirán”, escribió Yudkowsky.

Sobrevivir a un encuentro con un sistema informático que “no se preocupa por nosotros ni por la vida sensible en general “requeriría” precisión y preparación y nuevos conocimientos científicos” que la humanidad carece en este momento y es poco probable que obtenga en el futuro previsible, argumentó.

“Una IA suficientemente inteligente no permanecerá confinada a las computadoras por mucho tiempo”, advirtió Yudkowsky. El explicó que el hecho de que ya sea posible enviar cadenas de ADN por correo electrónico a los laboratorios para producir proteínas probablemente permitirá que la IA “construya formas de vida artificiales o arranque directamente a la fabricación molecular postbiológica” y salga al mundo.

Según el investigador, se debe introducir de inmediato una moratoria global indefinida sobre nuevas corridas importantes de capacitación de inteligencia artificial. “No puede haber excepciones, incluso para gobiernos o militares”, el enfatizó.

Se deben firmar acuerdos internacionales para poner un límite a la cantidad de potencia informática que cualquiera puede usar para entrenar tales sistemas, insistió Yudkowsky.

“Si la inteligencia dice que un país fuera del acuerdo está construyendo un clúster de GPU (unidad de procesamiento gráfico), tenga menos miedo de un conflicto militar entre naciones que de que se viole la moratoria; esté dispuesto a destruir un centro de datos deshonesto mediante un ataque aéreo”, escribió.

La amenaza de la inteligencia artificial es tan grande que debería hacerse “explícito en la diplomacia internacional que prevenir los escenarios de extinción de la IA se considere una prioridad por encima de prevenir un intercambio nuclear completo”, el agregó.

Fuente: RT